Perplexity 採用多模型系統,其 Sonar 模型建於 Llama 3.1 70B 上,並與 Llama 3.1 70B 搭配使用。 高級法學碩士 如 GPT 5.2, 克勞德 4.5, gemi 3 pro, 、Grok 4.1 和 Kimi K2。而不是依賴單一模型、, 困惑 將每項查詢路由至最適合搜尋、推理、編碼或多模態任務的模型。與任何單獨的 LLM 相比,這種組合能實現更快速的檢索、更精確的引文和更深入的推理。.

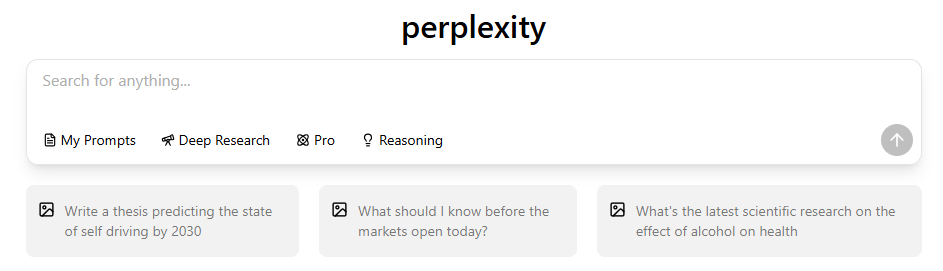

即使有 Perplexity 內建的機型切換功能,對於許多同樣需要工具來處理不同狀況的使用者來說,仍然是不夠的。許多人還想一起使用 GPT-5.2 和 Gemini 3 Pro 等頂級機型進行比較和研究。這帶出了一個實際的問題:是否有一個單一的地方可以存取頂級機型,而不需要跨平台移動?如果您發現自己需要更多的彈性,請探索 困惑替代方案 可能是正確的一步。.

GlobalGPT 透過整合 100 多種人工智慧模型來填補此缺口—包括 GPT-5.2,, 克勞德 4.5,, Sora 2 Pro, Veo 3.1,, 以及即時搜尋模型——整合於單一介面中,讓您無需維持多重訂閱即可輕鬆測試、比較與運用不同大型語言模型,所有方案均以約$5.75起價。.

什麼 法學碩士 權力 困惑在2026年?

Perplexity採用協調式多模型系統,而非單一AI模型。該平台會評估您的查詢內容,識別其意圖,並將查詢路由至最能產生精準、來源佐證或高度推理回應的大型語言模型。關鍵特點包括:

- Perplexity 可同時執行多個 LLM。如果您想知道 Perplexity 是否使用 ChatGPT, 我們的答案是,它將 OpenAI 的模型與其他模型整合在一起,但並非完全依賴這些模型。.

- 聲納 把柄 實時 搜尋, 檢索、摘要生成與排序。.

- GPT-5.2, Claude 4.5、, 雙子座3號專業版,Grok 4.1,, 以及 Kimi K2 處理進階推理, 編碼、多模態提示或趨勢敏感任務。.

- 多模型架構提升事實準確性, 因為不同的大型語言模型在不同的任務上各有專長。.

- 路由具備意圖感知能力, 這意味著Perplexity會判斷請求屬於搜尋、推理、編碼或創意的哪一類。.

- 此方法可減少幻覺 相較於單一模型聊天機器人。.

| 型號名稱 | 供應商 | 專業領域 | 核心優勢 | 典型查詢類型 |

| 聲納(基於 Llama 3.1 70B) | 困惑 | 即時檢索與搜尋排名 | 快速生成引用、高度新鮮度、可靠的事實基礎 | 新聞查詢、事實查核、最新研究、多來源綜合分析 |

| pplx-7b-線上 | 困惑度(基於Mistral-7B微調) | 輕量級線上大型語言模型,支援網頁片段 | 高度新鮮度、精準簡短回答、快速回應 | 快速事實查詢、熱門話題、時效性查詢 |

| pplx-70b-線上 | 困惑度(由Llama2-70B微調而成) | 重量級線上大型語言模型,具備更深層的推理能力 | 高事實性、強烈的整體性反應、減少幻覺 | 複雜的事實提示、新鮮的數據集、技術查閱 |

| GPT-5.2 | OpenAI | 深度推理與結構化生成 | 強大的邏輯能力、高超的編碼能力、長時效性表現 | 論文寫作、多步驟推理、程式碼除錯、結構化規劃 |

| 克勞德 4.5 |

何謂 困惑’預設模型是什麼?它實際上做了什麼?

Perplexity 的預設模型並非 GPT、Claude 或 Sonar。它是一款輕量級、速度優化的模型,專為快速瀏覽與簡短檢索任務而設計。其存在目的在於為低複雜度提示提供迅捷的初步解答。.

主要特徵:

- 為速度而優化 而非深入的推理。.

- 主要用於免費方案 或用於簡單查詢。.

- 觸發最小運算, 降低延遲。.

- 自動切換至 聲納 當查詢需要引用或多個來源時。.

- 在複雜推理方面能力較弱, 編碼、程式設計或多步驟說明。.

- 設計用於減輕負載 在較重型號上仍能保持流暢體驗。.

深入探索聲納: 困惑’的 即時搜尋引擎

聲納是Perplexity用於檢索的主要引擎。基於 羊駝 3.1 70B, 它經過精密調校,能夠即時讀取、排序並整合來自多個網頁的資訊。.

聲納為何重要:

- 專為檢索而設計, 不僅是文字生成。.

- 並行讀取數十個網頁, ,然後彙整證據。.

- 自動提供引用, 提升信任與透明度。.

- 切換至推理模式 針對多步驟或模糊查詢。.

- 表現優於 GPT 以及克勞德關於最新情報, 尤其是新聞或持續發展的話題。.

- 提供快速的搜尋回應, 通常在毫秒之內。.

- 改善事實性 接地, 降低產生幻覺的風險。.

完整清單 大型語言模型 困惑 跨訂閱方案的使用方式

除了Sonar和預設模型外,Perplexity整合了數個頂尖大型語言模型。每個模型皆具備特定用途:

GPT-5.1 (OpenAI)

- 長篇論述的絕佳選擇

- 強大的編碼與除錯能力

- 擅長結構化規劃

- 較舊型號更低的幻覺發生率

克勞德 4.5 十四行詩(人類本位)

- 高度穩定的逐步推理

- 非常適合數學、邏輯與程式碼清晰度

- 高效且具備長輸入上下文

克勞德 4.5 作品集(僅限 Max 方案)

- 最深層的推理能力

- 最適合用於技術性、多步驟的說明

- 較慢但最精準

雙子座3號 專業 (Google)

Grok 4.1 (xAI)

- 最適合即時、趨勢敏感的查詢

- 流暢的對話節奏

Kimi K2(登月計畫)

- 以隱私為導向

- 適合謹慎、循序漸進的推理

為何 困惑 使用所有這些模型

- 不同的任務需要不同的優勢

- 專用大型語言模型表現優於通用型模型

- 路由可提升輸出品質與穩健性

如何 困惑’「最佳模式」選擇正確 法學碩士

困惑度分析您的查詢內容,以判斷哪個模型能產生最佳答案。.

路由因素包括:

- 這個問題是基於事實還是基於研究? → 聲納

- 這需要深入的推理嗎? → GPT-5.2 或 Claude

- 該查詢是否與趨勢或社群媒體相關? → Grok

- 是否涉及圖像或多模態元素? → 雙子座

- 隱私是否令人擔憂? → Kimi K2

- 提示是否需要引用來源? → 聲納

額外行為:

- 推理模式切換 增加 GPT/Claude 的深度

- 搜尋模式 聲納系統

- 專業搜尋 擴展檢索範圍與來源

並列比較: 困惑 大型語言模型 及其理想用途

Perplexity 的大型語言模型專精於不同任務。. 以下是它們的比較:

- 最注重事實準確性: 聲納

- 最適合複雜推理: GPT-5.2

- 最適合邏輯清晰度: 克勞德 4.5

- 最適合多模態任務: 雙子座3號專業版

- 最適合 實時 上下文: Grok 4.1

- 最適合注重隱私的提示: Kimi K2

- 最適合日常綜合用途: 最佳模式自動路由

困惑vs 聊天GPTvs 克勞德 vs 雙子座

儘管Perplexity採用了許多相同的底層模型,但其架構有所不同:

- 困惑 擅長:

- 事實檢索

- 多來源綜合

- 引文支持的答案

- 快速新聞摘要

- 聊天GPT 擅長:

- 創意寫作

- 延伸推理序列

- 結構化規劃

- 克勞德擅長:

- 編碼

- 數學

- 邏輯分析

- 雙子座擅長:

- 圖像與影片解讀

- 多模態工作流程

何時使用每種模型內部 困惑

實用指引:

- 使用聲納 當您需要基於事實的解答、引用來源或即時資訊時。.

- 使用 GPT-5.2 f或邏輯密集的論文,, 解釋與多步驟推理。.

- 使用克勞德 4.5 用於編碼任務、數學證明及結構化分析。.

- 使用雙子座3專業版 用於圖像相關任務或影片理解。.

- 使用 Grok 4.1 用於熱門話題、社群媒體洞察或對話任務。.

- 使用 Kimi K2 當需要隱私或謹慎推理時。.

真實案例 困惑 模型切換

Perplexity 自動路由的範例:

- 突發新聞 查詢 → 聲納(快速檢索 + 引用)

- 除錯 Python 程式碼 → Claude 4.5 或 GPT-5.2

- 識別圖像 → 雙子星3 Pro

- 查詢熱門迷因 → Grok 4.1

- 長邏輯分解 → GPT-5.2 或 Claude Opus

定價層級與 法學碩士 存取

瞭解 困惑訂閱計劃 是了解您可以存取哪些機型的關鍵。.

| 層級 | 包含的模型 | 主要限制 |

| 免費 | – 預設模型(依負載而異)– 有限聲納存取 | – 無聲納大型版 – 速率限制 – 無進階檔案上傳 – 無 API 信用額度 |

| 專業 | - 小型聲納 - 大型聲納 - pplx-7b-online / pplx-70b-online (via 實驗室) | - 對於繁重的工作流程仍有限制 - 某些機型無法保證峰值時間效能 - 每月上限 API 信用額度 |

| 企業/團隊 | – 自訂模型路由 – 完整聲納堆疊 – pplx-online 家族 – 專用基礎設施選項 | – 需簽訂合約 – 價格因情況而異 – 需進行整合作業 |

各方案包含內容:

- 免費方案:

- 預設模型

- 有限聲納

- 無 GPT/Claude/Gemini 存取權限

- 專業 計劃:

- 聲納

- GPT-5.2

- 克勞德 4.5 十四行詩

- 雙子座3號專業版

- Grok 4.1

- Kimi K2

您可以查看完整的 Perplexity Pro 的優點 這裡。.

- 馬克斯計劃:

- 全系列專業型號

- 克勞德 4.5 作品集

- 額外的檢索深度

進一步了解 什麼是 Perplexity Max? 看看是否適合您。.

限制 困惑’的多模型系統

儘管具備優勢,Perplexity 仍存在限制:

- 機型供應情況因地區而異

- 沒有像ChatGPT這樣的插件生態系統

- 創意生成能力弱於專用工具

- 某些任務仍需人工進行事實核查

- 路由並非總是可預測的

- 多模態任務的靈活性仍不及專用平台。.

困惑度 vs ChatGPT vs Claude vs Gemini

雖然 Perplexity 使用許多相同的底層模型,但其架構有所不同。如需直接比較,請參閱我們對 Perplexity vs ChatGPT 2025.

- 困惑在以下方面表現出色: 事實檢索、多源綜合、引文支持答案。.

- ChatGPT 擅長於 創意寫作、延伸推理序列。.

- 克勞德擅長: 編碼、數學、邏輯分析。.

- 雙子座擅長: 影像 + 視訊詮釋、多模態工作流程。.

常見問題 關於 困惑’的 大型語言模型

- Perplexity 主要使用 GPT 嗎?→ 不,它使用多種模型。.

- 聲納比GPT更好嗎?→ 對於檢索任務而言,是的。.

- 能否強制指定特定模型?→ 僅能透過專業搜尋功能實現。.

- Perplexity 是否儲存資料?→ 根據官方文件,資料使用範圍有限且以隱私為核心。.

- 為何不同模型產生的答案聽起來相似?→ 共享的訓練資料與相似的對齊方法。.

最終思考 困惑’的多模型策略

Perplexity 的多模型架構展現了檢索優先的人工智慧系統如何在事實任務、文獻引用與快速研究方面,超越單一模型的聊天機器人。.

對於工作流程橫跨多種人工智慧能力(如搜尋、推理、寫作及多模態任務)的使用者而言,理解這些差異有助於優化輸出成果與工具選擇。您亦可比較這些模型的表現差異。 使用GlobalGPT並行運作,, 這將許多頂尖的大型語言模型整合至單一介面,便於進行評估。.