Perplexity gebruikt een multi-model systeem dat wordt aangedreven door zijn eigen Sonar-model, gebouwd op Llama 3.1 70B, naast gevorderde LLM's zoals GPT 5.2, Claude 4,5, gemi 3 pro, Grok 4.1 en Kimi K2. In plaats van te vertrouwen op één model, verbijstering routeert elke zoekopdracht naar het model dat het meest geschikt is voor zoeken, redeneren, coderen of multimodale taken. Deze combinatie maakt sneller zoeken, nauwkeuriger citeren en dieper redeneren mogelijk dan een enkele LLM alleen.

Zelfs met Perplexity's ingebouwde modelswitching is het nog steeds niet genoeg voor veel gebruikers die ook tools nodig hebben voor verschillende situaties. Velen willen ook topmodellen zoals GPT-5.2 en Gemini 3 Pro samen gebruiken voor vergelijking en onderzoek. Dat werpt een praktische vraag op: is er één plek om toegang te krijgen tot topmodellen zonder van platform te hoeven wisselen? Als je meer flexibiliteit nodig hebt, kun je het volgende onderzoeken Perplexiteit alternatieven zou de juiste stap kunnen zijn.

GlobalGPT vult die leemte door meer dan 100 AI-modellen te combineren.—inclusief GPT-5.2, Claude 4.5, Sora 2 Pro, Veo 3.1, en realtime zoekmodellen – binnen één enkele interface, waardoor het eenvoudiger wordt om verschillende LLM's te testen, te vergelijken en te gebruiken zonder meerdere abonnementen te hoeven onderhouden, allemaal vanaf ongeveer $5,75.

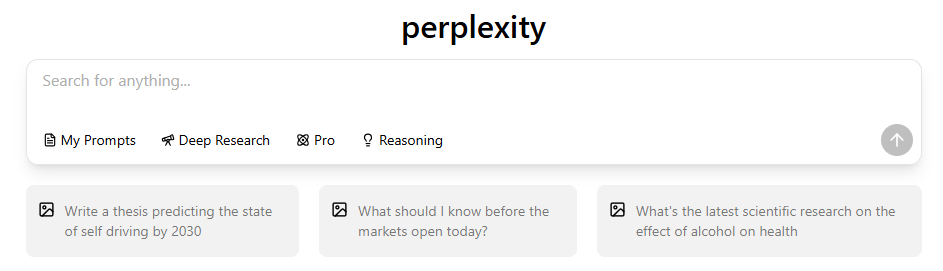

Wat LLM Bevoegdheden Perplexiteitin 2026?

Perplexity maakt gebruik van een gecoördineerd multimodelsysteem in plaats van één enkel AI-model. Het platform evalueert uw zoekopdracht, identificeert de intentie ervan en stuurt deze door naar het LLM dat het meest geschikt is om een nauwkeurig, door bronnen ondersteund of op redeneringen gebaseerd antwoord te geven. De belangrijkste punten zijn:

- Perplexity voert meerdere LLM's tegelijk uit. Als je je afvraagt gebruikt Perplexity ChatGPT, Het antwoord is dat het OpenAI-modellen integreert naast andere modellen, maar er niet exclusief op vertrouwt.

- Sonar handvatten real-time zoek, ophalen, samenvatten en rangschikken.

- GPT-5.2, Claude 4.5, Gemini 3 Pro,Grok 4.1, en Kimi K2 kunnen geavanceerde redeneringen uitvoeren, codering, multimodale prompts of trendgevoelige taken.

- De multi-modelarchitectuur verbetert de feitelijke nauwkeurigheid., omdat verschillende LLM's uitblinken in verschillende taken.

- Routing is intentiebewust, wat betekent dat Perplexity interpreteert of het verzoek een zoekopdracht, redenering, codering of creatief is.

- Deze aanpak vermindert hallucinaties. in vergelijking met chatbots met één model.

| Modelnaam | Aanbieder | Specialiteit | Sterke punten | Typische soorten zoekopdrachten |

| Sonar (gebaseerd op Llama 3.1 70B) | Perplexiteit | Realtime opvragen en zoekresultaten rangschikken | Snelle citatiegeneratie, hoge actualiteit, betrouwbare feitelijke onderbouwing | Nieuwsvragen, feitencontrole, actueel onderzoek, synthese uit meerdere bronnen |

| pplx-7b-online | Verwarring (fijnafgestemd vanuit Mistral-7B) | Lichtgewicht online LLM met websnippets | Hoge versheid, nauwkeurige korte antwoorden, snelle reacties | Snelle feitelijke zoekopdrachten, trending topics, tijdgevoelige zoekopdrachten |

| pplx-70b-online | Verwarring (fijnafgestemd vanuit Llama2-70B) | Zwaarwegende online LLM met diepgaander redeneren | Hoge factualiteit, sterke holistische reacties, verminderde hallucinaties | Complexe feitelijke prompts, nieuwe datasets, technische opzoekingen |

| GPT-5.2 | OpenAI | Diepgaande redenering en gestructureerde generatie | Sterke logica, hoog programmeervermogen, prestaties in een lange context | Essays, meerstapsredeneringen, foutopsporing in code, gestructureerde planning |

| Claude 4.5 |

Wat is Perplexiteit’Het standaardmodel van en wat doet het eigenlijk?

Het standaardmodel van Perplexity is niet GPT, Claude of Sonar. Het is een lichtgewicht, voor snelheid geoptimaliseerd model dat is ontworpen voor snel browsen en korte zoekopdrachten. Het is bedoeld om snelle eerste antwoorden te geven op vragen met een lage complexiteit.

Belangrijkste kenmerken:

- Geoptimaliseerd voor snelheid in plaats van diepgaande redeneringen.

- Voornamelijk gebruikt in het gratis abonnement of voor eenvoudige zoekopdrachten.

- Veroorzaakt minimale berekening, waardoor de latentie wordt verminderd.

- Schakelt automatisch over naar Sonar wanneer een zoekopdracht citaten of meerdere bronnen vereist.

- Minder bekwaam in complex redeneren, codering of uitleg in meerdere stappen.

- Ontworpen om de belasting te verminderen op zwaardere modellen, terwijl de ervaring soepel blijft.

Diepgaande analyse van Sonar: Perplexiteit’s Real-timeZoekmachine

Sonar is de belangrijkste engine van Perplexity voor het ophalen van informatie. Gebouwd op Lama 3.1 70B, Het is nauwkeurig afgestemd om informatie van meerdere webpagina's in realtime te lezen, te rangschikken en te synthetiseren.

Waarom Sonar belangrijk is:

- Speciaal ontworpen voor het ophalen van gegevens, niet alleen tekstgeneratie.

- Leest tientallen webpagina's tegelijkertijd, en verzamelt vervolgens bewijsmateriaal.

- Geeft automatisch citaten weer, waardoor het vertrouwen en de transparantie worden verbeterd.

- Schakelt over naar redeneermodus voor meerstaps- of dubbelzinnige zoekopdrachten.

- Presteert beter dan GPT en Claude over nieuwe informatie, vooral nieuws of actuele onderwerpen.

- Levert snelle zoekresultaten, vaak binnen milliseconden.

- Verbetert de feitelijke informatie aardverbinding, waardoor het risico op hallucinaties wordt verminderd.

Volledige lijst van LLM's Perplexiteit Gebruik in verschillende abonnementen

Naast Sonar en het standaardmodel integreert Perplexity verschillende vooraanstaande LLM's. Elk daarvan heeft een specifiek doel:

GPT-5.1 (OpenAI)

- Uitstekend geschikt voor langdurige redeneringen

- Sterke codering en foutopsporing

- Goed in gestructureerd plannen

- Lagere hallucinatiegraad ten opzichte van oudere modellen

Claude 4.5 Sonnet (Antropisch)

- Zeer stabiele stapsgewijze redenering

- Geweldig voor wiskunde, logica en duidelijkheid van code

- Efficiënt met lange invoercontexten

Claude 4.5 Opus (alleen Max-abonnementen)

- Diepste redeneervermogen

- Het meest geschikt voor technische, meerstapsuitleg

- Langzamer maar uiterst nauwkeurig

Tweelingen 3 Pro (Google)

- Beste multimodale begrip

- sterke beeld-/videoredenering

- Geweldig voor het schrijven en analyseren van code

- Het wordt vaak vergeleken in onze Tweelingen vs Perplexiteit gids.

Grok 4.1 (xAI)

- Het meest geschikt voor realtime, trendgevoelige zoekopdrachten

- Uitstekende gespreksstroom

Kimi K2 (Moonshot)

- Privacygericht

- Goed voor zorgvuldig, stapsgewijs redeneren

Waarom Perplexiteit gebruikt al deze modellen

- Verschillende taken vereisen verschillende sterke punten.

- Gespecialiseerde LLM's presteren beter dan algemene LLM's

- Routing verbetert de uitvoerkwaliteit en robuustheid

Hoe Perplexiteit’s “Beste modus” kiest de juiste LLM

Perplexity analyseert uw zoekopdracht om te bepalen welk model het beste antwoord geeft.

Routeringsfactoren zijn onder meer:

- Is de vraag feitelijk of gebaseerd op onderzoek? → Sonar

- Is daarvoor diepgaand redeneren nodig? → GPT-5.2 of Claude

- Is de zoekopdracht trending of gerelateerd aan sociale media? → Grok

- Gaat het om afbeeldingen of multimodale elementen? → Tweelingen

- Is privacy een punt van zorg? → Kimi K2

- Moeten er bronvermeldingen worden gebruikt? → Sonar

Extra gedrag:

- Redeneringsmodus omschakelen vergroot de diepgang van GPT/Claude

- Zoekmodus krachten Sonar

- Pro zoeken breidt het zoekbereik en de bronnen uit

Vergelijking naast elkaar: Perplexiteit LLM's en hun ideale toepassingen

De LLM's van Perplexity zijn gespecialiseerd in verschillende taken. Hier is een vergelijking:

- Beste voor feitelijke nauwkeurigheid: Sonar

- Het beste voor complexe redeneringen: GPT-5.2

- Het beste voor logische duidelijkheid: Claude 4.5

- Het beste voor multimodale taken: Gemini 3 Pro

- Geschikt voor real-time context: Grok 4.1

- Het beste voor privacygevoelige prompts: Kimi K2

- Het beste voor dagelijks gemengd gebruik: Beste modus voor automatische routebepaling

Perplexiteitvs ChatGPTvs Claude vs Gemini

Hoewel Perplexity veel van dezelfde onderliggende modellen gebruikt, verschilt de architectuur ervan:

- Perplexiteit blinkt uit in:

- feiten opzoeken

- synthese uit meerdere bronnen

- antwoorden met bronvermelding

- snelle nieuwssamenvatting

- ChatGPT blinkt uit in:

- creatief schrijven

- uitgebreide redeneerprocessen

- gestructureerde planning

- Claude blinkt uit in:

- codering

- wiskunde

- logische analyse

- Gemini blinkt uit in:

- beeld + video-interpretatie

- multimodale workflows

Wanneer elk model binnen gebruiken Perplexiteit

Praktische richtlijnen:

- Gebruik Sonar wanneer je op feiten gebaseerde antwoorden, citaten of realtime informatie nodig hebt.

- Gebruik GPT-5.2 fof logische essays, uitleg en redeneringen in meerdere stappen.

- Gebruik Claude 4.5 voor coderingstaken, wiskundige bewijzen en gestructureerde analyse.

- Gebruik Gemini 3 Pro voor beeldgerelateerde taken of video-begrip.

- Gebruik Grok 4.1 voor trending topics, inzichten op sociale media of conversatietaken.

- Gebruik Kimi K2 wanneer privacy of zorgvuldige afwegingen nodig zijn.

Echte voorbeelden van Perplexiteit Modelwisseling

Voorbeelden van automatische routering door Perplexity:

- Laatste nieuws query → Sonar (snel zoeken + citaten)

- Python-code debuggen → Claude 4.5 of GPT-5.2

- Een afbeelding identificeren → Gemini 3 Pro

- Een populaire meme opzoeken → Grok 4.1

- Lange logische decompositie → GPT-5.2 of Claude Opus

Prijsniveaus en LLM Toegang

Inzicht in de Perplexiteit abonnementsplannen is de sleutel om te weten tot welke modellen je toegang hebt.

| Niveau | Modellen inbegrepen | Belangrijkste beperkingen |

| Gratis | – Standaardmodel (varieert per belasting) – Beperkte toegang tot sonar | – Geen Sonar Large – Snelheidslimieten – Geen geavanceerde bestandsuploads – Geen API-credits |

| Pro | - Sonar klein - Sonar groot - pplx-7b-online / pplx-70b-online (via Laboratoria) | - Nog steeds beperkt voor zware workflows - Geen gegarandeerde piekprestaties voor sommige modellen - Maandelijkse limiet op API-kredieten |

| Onderneming / Teams | – Aangepaste modelroutering – Volledige Sonar-stack – pplx-online-familie – Speciale infrastructuuropties | – Contract vereist – Prijzen variëren – Integratiewerkzaamheden nodig |

Wat elk plan omvat:

- Gratis plan:

- Standaardmodel

- Beperkte sonar

- Geen toegang tot GPT/Claude/Gemini

- Pro Plan:

- Sonar

- GPT-5.2

- Claude 4.5 Sonnet

- Gemini 3 Pro

- Grok 4.1

- Kimi K2

Je kunt de volledige lijst van Voordelen van Perplexity Pro hier.

- Max Plan:

- Alle Pro-modellen

- Claude 4.5 Opus

- Extra opvraagdiepte

Meer informatie over wat is Perplexity Max om te zien of het iets voor jou is.

Beperkingen van Perplexiteit’Het multimodale systeem van

Ondanks zijn sterke punten heeft Perplexity ook beperkingen:

- De beschikbaarheid van modellen verschilt per regio.

- Geen plug-in-ecosysteem zoals ChatGPT

- Creatieve generatie zwakker dan speciale tools

- Sommige taken vereisen nog steeds handmatige controle van feiten.

- Routing is niet altijd voorspelbaar

- Multimodale taken blijven minder flexibel dan gespecialiseerde platforms.

Perplexiteit vs ChatGPT vs Claude vs Gemini

Hoewel Perplexity veel van dezelfde onderliggende modellen gebruikt, verschilt de architectuur. Voor een directe vergelijking, zie onze analyse van Perplexiteit vs ChatGPT 2025.

- Perplexity blinkt uit in: fact retrieval, multi-source synthese, citatie-gebaseerde antwoorden.

- ChatGPT blinkt uit in: creatief schrijven, sequenties voor uitgebreid redeneren.

- Claude blinkt uit in: codering, wiskunde, logische analyse.

- Gemini blinkt uit in: beeld- en video-interpretatie, multimodale workflows.

FAQ Over Perplexiteit’s LLM's

- Gebruikt Perplexity voornamelijk GPT? → Nee, het gebruikt veel modellen.

- Is Sonar beter dan GPT? → Voor zoekopdrachten wel.

- Kan ik een specifiek model afdwingen? → Alleen via Pro Search.

- Slaat Perplexity gegevens op? → Volgens officiële documenten is het gebruik van gegevens beperkt en gericht op privacy.

- Waarom klinken de antwoorden bij alle modellen hetzelfde? → Gedeelde trainingsgegevens en vergelijkbare afstemmingsmethoden.

Laatste gedachten over Perplexiteit’De multimodelstrategie van

De multimodelarchitectuur van Perplexity laat zien hoe AI-systemen die zich eerst richten op het ophalen van informatie beter presteren dan chatbots met één model bij feitelijke taken, citaten en snel onderzoek.

Voor gebruikers wier workflows meerdere AI-mogelijkheden omvatten – zoeken, redeneren, schrijven en multimodale taken – helpt het begrijpen van deze verschillen bij het optimaliseren van de output en de keuze van tools. U kunt ook vergelijken hoe deze modellen gedraag je naast elkaar met behulp van GlobalGPT, waardoor veel van dezelfde top-LLM's in één interface worden samengebracht voor een eenvoudigere evaluatie.