Perplexity utiliza un sistema multimodelo alimentado por su propio modelo Sonar -construido sobre Llama 3.1 70B- junto a LLM avanzados como GPT 5.2, Claude 4,5, gemi 3 pro, Grok 4.1 y Kimi K2. En lugar de depender de un único modelo, perplejidad dirige cada consulta al modelo más adecuado para las tareas de búsqueda, razonamiento, codificación o multimodales. Esta combinación permite una recuperación más rápida, citas más precisas y un razonamiento más profundo que cualquier LLM por sí solo.

Incluso con el cambio de modelo integrado en Perplexity, sigue sin ser suficiente para muchos usuarios que también necesitan herramientas para diferentes situaciones. Muchos también quieren utilizar los mejores modelos, como GPT-5.2 y Gemini 3 Pro, para comparar e investigar. Esto plantea una cuestión práctica: ¿existe un lugar único para acceder a los mejores modelos sin tener que moverse de una plataforma a otra? Si necesita más flexibilidad, explore Alternativas a la perplejidad podría ser el paso correcto.

GlobalGPT aborda esa brecha combinando más de 100 modelos de IA.—incluido GPT-5.2, Claude 4.5, Sora 2 Pro, Veo 3.1, y modelos de búsqueda en tiempo real, todo ello en una única interfaz, lo que facilita probar, comparar y utilizar diferentes LLM sin necesidad de mantener múltiples suscripciones, todo ello a partir de aproximadamente 1 TP4T5,75.

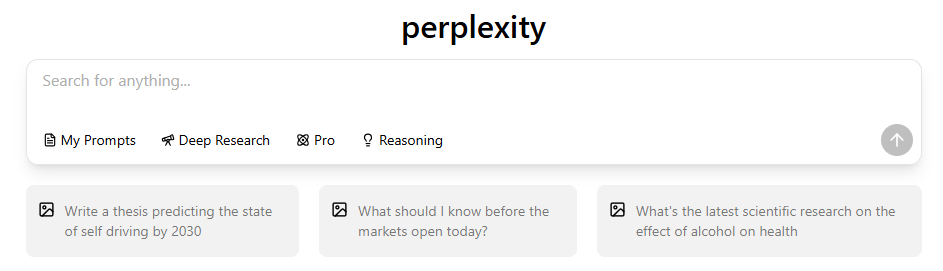

¿Qué? LLM Poderes Perplejidad¿En 2026?

Perplexity utiliza un sistema multimodelo coordinado en lugar de un único modelo de IA. La plataforma evalúa tu consulta, identifica su intención y la envía al LLM más capaz de producir una respuesta precisa, respaldada por fuentes o basada en un razonamiento sólido. Los puntos clave incluyen:

- Perplexity ejecuta múltiples LLM simultáneamente. Si se pregunta ¿utiliza Perplexity ChatGPT, La respuesta es que integra los modelos de OpenAI junto con otros, pero no se basa exclusivamente en ellos.

- Sonda manijas en tiempo real busque en, recuperación, resumen y clasificación.

- GPT-5.2, Claude 4.5, Géminis 3 Pro,Grok 4.1, y Kimi K2 manejan el razonamiento avanzado., codificación, indicaciones multimodales o tareas sensibles a las tendencias.

- La arquitectura multimodelo mejora la precisión factual., porque los diferentes LLM destacan en diferentes tareas.

- El enrutamiento es consciente de la intención., lo que significa que Perplexity interpreta si la solicitud es una búsqueda, un razonamiento, una codificación o una creación.

- Este enfoque reduce las alucinaciones. en comparación con los chatbots de modelo único.

| Nombre del modelo | Proveedor | Especialidad | Puntos fuertes | Tipos de consultas típicas |

| Sonar (basado en Llama 3.1 70B) | Perplejidad | Recuperación en tiempo real y clasificación de búsquedas | Fast citation generation, high freshness, reliable factual grounding | Consultas sobre noticias, verificación de datos, investigación actualizada, síntesis de múltiples fuentes. |

| pplx-7b-en línea | Perplejidad (ajustada a partir de Mistral-7B) | LLM ligero en línea con fragmentos web | Gran frescura, respuestas breves y precisas, respuestas rápidas. | Búsquedas rápidas de datos, temas de actualidad, consultas urgentes. |

| pplx-70b-en línea | Perplejidad (ajustada a partir de Llama2-70B) | LLM online de peso pesado con razonamiento más profundo | Alta objetividad, respuestas holísticas sólidas, reducción de las alucinaciones. | Indicaciones factuales complejas, conjuntos de datos nuevos, consultas técnicas. |

| GPT-5.2 | OpenAI | Razonamiento profundo y generación estructurada | Lógica sólida, gran capacidad de codificación, rendimiento en contextos largos. | Ensayos, razonamiento en varios pasos, depuración de código, planificación estructurada. |

| Claude 4.5 |

Qué es Perplejidad’¿Cuál es el modelo predeterminado y qué hace realmente?

El modelo predeterminado de Perplexity no es GPT, Claude ni Sonar. Se trata de un modelo ligero y optimizado para la velocidad, diseñado para tareas de navegación rápida y recuperación breve. Su finalidad es proporcionar respuestas rápidas en una primera pasada para consultas de baja complejidad.

Características principales:

- Optimizado para la velocidad en lugar de un razonamiento profundo.

- Se utiliza principalmente en el plan gratuito. o para consultas sencillas.

- Desencadena un cálculo mínimo., reduciendo la latencia.

- Cambia automáticamente a Sonda cuando una consulta requiere citas o múltiples fuentes.

- Menos capaz en razonamientos complejos., codificación o explicaciones de varios pasos.

- Diseñado para reducir la carga en modelos más pesados, manteniendo una experiencia fluida.

Profundiza en Sonar: Perplejidad’s En tiempo realMotor de búsqueda

Sonar es el motor principal de Perplexity para la recuperación. Basado en Llama 3.1 70B, está optimizado para leer, clasificar y sintetizar información de múltiples páginas web en tiempo real.

Por qué es importante Sonar:

- Diseñado específicamente para la recuperación, no solo la generación de texto.

- Lee docenas de páginas web en paralelo., y luego agrega las pruebas.

- Proporciona citas automáticamente., mejorando la confianza y la transparencia.

- Pasa al modo de razonamiento. para consultas de varios pasos o ambiguas.

- Supera GPT y Claude sobre información reciente, especialmente noticias o temas en evolución.

- Ofrece respuestas rápidas a las búsquedas., a menudo en milisegundos.

- Mejora los datos objetivos. conexión a tierra, reduciendo el riesgo de alucinaciones.

Lista completa de LLMs Perplejidad Usos en los planes de suscripción

Más allá de Sonar y del modelo predeterminado, Perplexity integra varios LLM de primer nivel. Cada uno tiene un propósito específico:

GPT-5.1 (OpenAI)

- Excelente para razonamientos extensos.

- Codificación y depuración sólidas

- Bueno en la planificación estructurada

- Menor índice de alucinaciones en comparación con los modelos anteriores.

Claude 4.5 Soneto (Antrópico)

- Razonamiento paso a paso altamente estable

- Ideal para matemáticas, lógica y claridad de código.

- Eficiente con contextos de entrada largos

Claude 4.5 Opus (solo planes Max)

- Capacidades de razonamiento más profundas

- Ideal para explicaciones técnicas y de varios pasos.

- Más lento pero más preciso

Géminis 3 Pro (Google)

- Mejor comprensión multimodal

- razonamiento sólido de imágenes/vídeos

- Ideal para escribir y analizar código.

- A menudo se compara en nuestro Géminis vs Perplejidad guía.

Grok 4.1 (xAI)

- Ideal para consultas en tiempo real y sensibles a las tendencias.

- Excelente fluidez conversacional

Kimi K2 (Moonshot)

- Orientado a la privacidad

- Bueno para un razonamiento cuidadoso y paso a paso.

Por qué Perplejidad utiliza todos estos modelos

- Las diferentes tareas requieren diferentes fortalezas.

- Los LLM especializados superan a los de uso general.

- El enrutamiento mejora la calidad y la solidez de la salida.

¿Cómo? Perplejidad’El “modo óptimo” elige el adecuado. LLM

Perplexity analiza tu consulta para determinar qué modelo produce la mejor respuesta.

Los factores de enrutamiento incluyen:

- ¿La pregunta se basa en hechos o en investigaciones? → Sonar

- ¿Requiere un razonamiento profundo? → GPT-5.2 o Claude

- ¿La consulta es tendencia o está relacionada con las redes sociales? → Grok

- ¿Incluye imágenes o elementos multimodales? → Géminis

- ¿Te preocupa la privacidad? → Kimi K2

- ¿El mensaje requiere citas? → Sonar

Comportamiento adicional:

- Alternar modo de razonamiento Aumenta la profundidad de GPT/Claude.

- Modo de búsqueda fuerzas Sonar

- Búsqueda profesional amplía el alcance y las fuentes de recuperación

Comparación lado a lado: Perplejidad LLMs y sus usos ideales

Los LLM de Perplexity se especializan en diferentes tareas. Aquí está cómo se comparan:

- Lo mejor en cuanto a precisión factual: Sonda

- Lo mejor para el razonamiento complejo: GPT-5.2

- Lo mejor para la claridad lógica: Claude 4.5

- Lo mejor para tareas multimodales: Géminis 3 Pro

- Lo mejor para en tiempo real contexto: Grok 4.1

- Lo mejor para indicaciones sensibles a la privacidad: Kimi K2

- Lo mejor para un uso mixto diario: Mejor modo de enrutamiento automático

Perplejidadvs ChatGPTvs Claude vs Géminis

Aunque Perplexity utiliza muchos de los mismos modelos subyacentes, su arquitectura es diferente:

- Perplejidad destaca en:

- recuperación de datos

- síntesis de múltiples fuentes

- respuestas respaldadas por citas

- resumen rápido de noticias

- ChatGPT destaca en:

- escritura creativa

- Secuencias de razonamiento ampliadas

- planificación estructurada

- Claude destaca en:

- codificación

- matemáticas

- análisis lógico

- Géminis destaca en:

- interpretación de imágenes + vídeos

- flujos de trabajo multimodales

Cuándo utilizar cada modelo en el interior Perplejidad

Orientación práctica:

- Utilizar el sonar cuando necesitas respuestas basadas en hechos, citas o información en tiempo real.

- Utilizar GPT-5.2 fo ensayos con gran carga lógica, explicaciones y razonamientos de varios pasos.

- Utiliza Claude 4.5 para tareas de codificación, demostraciones matemáticas y análisis estructurado.

- Utiliza Gemini 3 Pro para tareas relacionadas con imágenes o comprensión de vídeos.

- Utilice Grok 4.1 para temas de actualidad, información sobre redes sociales o tareas conversacionales.

- Utiliza Kimi K2. cuando se necesita privacidad o un razonamiento cuidadoso.

Ejemplos reales de Perplejidad Cambio de modelo

Ejemplos del enrutamiento automático de Perplexity:

- Noticias de última hora consulta → Sonar (recuperación rápida + citas)

- Depuración de código Python → Claude 4.5 o GPT-5.2

- Identificar una imagen → Gemini 3 Pro

- Buscar un meme de tendencia → Grok 4.1

- Descomposición lógica larga → GPT-5.2 o Claude Opus

Niveles de precios y LLM Acceda a

Comprender la Planes de suscripción de perplejidad es clave para saber a qué modelos puede acceder.

| Nivel | Modelos incluidos | Limitaciones clave |

| Gratis | – Modelo predeterminado (varía según la carga) – Acceso limitado al sonar | – Sin Sonar Large – Límites de velocidad – Sin cargas avanzadas de archivos – Sin créditos API |

| Pro | - Sonar Pequeño - Sonar Grande - pplx-7b-online / pplx-70b-online (via Laboratorios) | - Aún limitado para flujos de trabajo pesados - No se garantiza el rendimiento en horas punta para algunos modelos - Límite mensual de Créditos API |

| Empresa / Equipos | – Enrutamiento de modelos personalizados – Pila completa de Sonar – Familia pplx-online – Opciones de infraestructura dedicadas | – Requiere contrato – Los precios varían – Se necesita trabajo de integración |

Lo que incluye cada plan:

- Plan gratuito:

- Modelo predeterminado

- Sonar limitado

- Sin acceso a GPT/Claude/Gemini

- Pro Plan:

- Sonda

- GPT-5.2

- Claude 4.5 Soneto

- Géminis 3 Pro

- Grok 4.1

- Kimi K2

Puede consultar la lista completa de Ventajas de Perplexity Pro aquí.

- Plan máximo:

- Todos los modelos Pro

- Claude 4.5 Opus

- Profundidad de recuperación adicional

Más información qué es Perplexity Max para ver si es adecuado para usted.

Limitaciones de Perplejidad’Sistema multimodelo de

A pesar de sus puntos fuertes, Perplexity tiene limitaciones:

- La disponibilidad de los modelos varía según la región.

- No hay un ecosistema de complementos como ChatGPT.

- La generación creativa es más débil que las herramientas específicas.

- Algunas tareas aún requieren una verificación manual de los datos.

- El enrutamiento no siempre es predecible.

- Las tareas multimodales siguen siendo menos flexibles que las plataformas especializadas.

Perplexity vs ChatGPT vs Claude vs Gemini

Aunque Perplexity utiliza muchos de los mismos modelos subyacentes, su arquitectura difiere. Para una comparación directa, véase nuestro análisis de Perplejidad vs ChatGPT 2025.

- Perplexity destaca en: recuperación de hechos, síntesis de múltiples fuentes, respuestas basadas en citas.

- ChatGPT destaca en: escritura creativa, secuencias de razonamiento ampliado.

- Claude destaca en: codificación, matemáticas, análisis lógico.

- Géminis destaca en: interpretación de imágenes y vídeos, flujos de trabajo multimodales.

PREGUNTAS FRECUENTES Acerca de Perplejidad’s LLMs

- ¿Perplexity utiliza principalmente GPT? → No, utiliza muchos modelos.

- ¿Es Sonar mejor que GPT? → Para tareas de recuperación, sí.

- ¿Puedo forzar un modelo específico? → Solo a través de la búsqueda profesional.

- ¿Perplexity almacena datos? → Según la documentación oficial, el uso de datos es limitado y se centra en la privacidad.

- ¿Por qué las respuestas suenan similares en todos los modelos? → Datos de entrenamiento compartidos y métodos de alineación similares.

Reflexiones finales sobre Perplejidad’Estrategia multimodelo de

La arquitectura multimodelo de Perplexity demuestra cómo los sistemas de IA basados en la recuperación pueden superar a los chatbots de modelo único en tareas basadas en hechos, citas y búsquedas rápidas.

Para los usuarios cuyos flujos de trabajo abarcan múltiples capacidades de IA (búsqueda, razonamiento, redacción y tareas multimodales), comprender estas diferencias ayuda a optimizar los resultados y la selección de herramientas. También puede comparar cómo estos modelos comportarse en paralelo utilizando GlobalGPT, que reúne muchos de los mejores LLM en una sola interfaz para facilitar su evaluación.