Perplexity 與 DeepSeek 扮演不同角色:DeepSeek 提供開放權重推理模型,如 R1 及未經審查的 R1-1776;而 Perplexity 則透過整合即時搜尋、多步驟規劃及自主報告生成功能,將這些模型轉化為完整的科研引擎。 至2025年,兩者關鍵差異在於:Perplexity透過檢索與驗證機制強化DeepSeek的原始推理能力,針對複雜或事實性問題能產出更可靠的結果。.

由於 Perplexity 和 DeepSeek 涵蓋了工作流程的不同部分,許多使用者透過結合兩者,或搭配統一搜尋、推理和創作的工具,獲得最佳的結果。如果您正在探索 困惑替代方案, 因此,瞭解這些模式的差異與整合方式至關重要。當這些功能集中在一個地方,而不是橫跨多個應用程式時,才會產生真正的價值。.

其實,, GlobalGPT 提供統一的一站式工作空間 您可在此獲取進階模型,僅需每月支付$5.75費用,即可輕鬆並行評估DeepSeek、Gemini、Claude或GPT-5.1等模型。.

如何 困惑 其系統內部採用 DeepSeek R1 及 R1-1776

| 模型版本 | 審查抗爭 | 推理深度 | 事實依據 | 整合與檢索 | 自主性等級 |

| DeepSeek R1(原始版) | 極低——在政治及敏感話題上極易引發拒絕反應 | 思路連貫但前後矛盾 | 中等;經常缺乏驗證 | 無 — 僅限模型 | 低(需使用者在每個步驟進行確認) |

| R1-1776(開放式重量) | 高 — 為求事實真相,未經審查的回答 | 與R1相同理由;結構略有改善 | 更高層級 — 包含受監督的事實性修正 | 無 | 低至中(仍為獨立型號) |

| 困惑度修正版 R1-1776 | 最高等級 — 審查緩解 + 拒絕繞過 | 基於代理人迴圈的更強效多步驟規劃 | 得益於即時檢索,速度大幅提升 | 深度整合搜尋、來源排序與過濾功能 | 高階 — 自主研究、多搜索工作流程 |

Perplexity 決定整合 DeepSeek R1——以及後續的未經審查版本 R1-1776—並非要取代現有架構,而是強化其深度研究引擎背後的推理核心。R1 提供長篇連貫思考鏈、多步驟推理,以及...在學術基準測試中的表現, 而R1-1776則移除了那些嚴格限制模型在政治、地緣政治及敏感事實查詢中運作的審查模式。.

若要瞭解此機型與其他機型的比較,請查看 Perplexity 使用何種 LLM.

困惑度在訓練後進行了額外應用 使R1-1776符合其平台目標:

- 移除帶有偏見或受國家影響的拒絕

- 透過檢索式回饋迴路強化事實基礎

- 提升推理能力以實現自主執行多搜索規劃任務

- 將模型整合至深度研究 工作流程

這就是為什麼Perplexity內部版本的R1-1776表現不同——且往往優於——在本地運行原始的DeepSeek開放權重模型。.

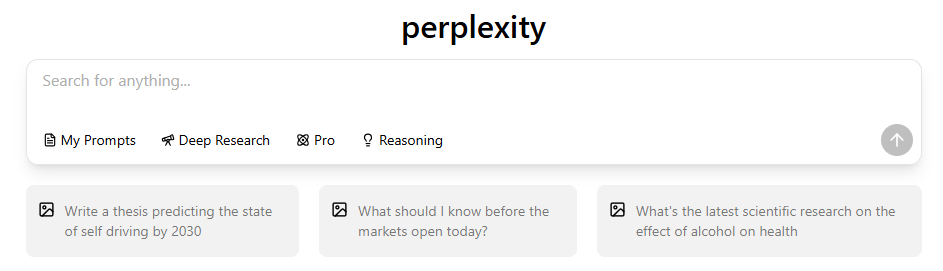

您先前上傳的 “「深度研究截圖」” 可在此處放置作為此過程的視覺說明。.

DeepSeek R1 與 R1-1776 的設計目的

DeepSeek R1 是一款專為長鏈式推理任務(如數學證明、邏輯謎題、多步驟規劃及學術評鑑)優化的開放式權重推理模型。其架構著重於結構化推理能力,而非創造力、對話深度或多模態特徵。.

未經審查的R1-1776版本透過修改安全層來消除政治性拒絕模式,使其在以下方面更為可靠:

- 地緣政治查詢

- 具爭議性的歷史分析

- 政策建模

- 敏感區域研究

- 意識形態偏見的議題

DeepSeek 模型是出色的推理引擎,但 非全人工智慧產品—它們缺乏即時搜尋、使用者介面、工作流程協調以及資料集檢索系統。.

如何 困惑’的 即時 檢索改變了R1的行為

即使是最優秀的推理模型,在與權威數據隔絕時也會產生幻覺。. Perplexity 透過在檢索引擎之上疊加 DeepSeek R1 來解決此問題:

- R1提出假說

- Perplexity 匯集數十個即時來源

- R1 運用經驗證的數據來精進推理

- 深度研究彙整最終結構化報告

此反饋迴路將R1從離線推理引擎轉變為 研究級自主系統.

對於需要更深入功能的使用者而言,這是 什麼是 Perplexity Max?.

這正是你的 深度研究介面截圖 完美契合。.

Perplexity 與 DeepSeek:核心差異(2025 年概覽)

| 功能/維度 | 困惑 | DeepSeek (R1 / R1-1776) |

| 查詢準確度 | 適用於事實性、時效性強且涉及多來源的查詢(以檢索為基礎) | 邏輯、數學與推理能力高;事實性查詢能力不穩定 |

| 敏感話題的處理方式 | 穩定型——採用檢索+過濾機制;較不易產生幻覺或拒絕回應 | R1經常拒絕回應;R1-1776雖會回應,但可能未經核實或存在矛盾 |

| 基準效能 | 雖非模型,但Deep Research在SimpleQA(93.9%)與人類終極考驗中表現亮眼 | R1 在推理基準測試中表現優異;R1-1776 表現相近但未經審查。 |

| 研究自主權 | 極高 — 多階段規劃、分支搜尋、綜合分析、文獻引用 | 低 — 單次生成,無搜索或規劃 |

| 即時搜尋 | 是的——整合網頁搜尋、來源排序、引用文獻擷取 | 不——模型在離線狀態下運作,無需檢索 |

| 使用者工作流程 | 完整工作流程:深度研究、PDF匯出、頁面管理、摘要整理、文獻引用、多來源整合 | 僅限模型;工作流程必須由開發人員自行建置 |

1. 模型 vs 產品

深度搜尋 是一種開放式重量 模型 專為開發者打造。. 困惑是一項完整的研發產品 — 結合模型與即時搜尋、來源排序、工作流程及精緻的使用者體驗。.

👉 DeepSeek 是一個元件;Perplexity 則是一個完整的系統。.

2. 推理與驗證答案

深度搜尋 提出強而有力的論證,但未提供檢索或引用依據。. 困惑 在外部來源中尋找每個答案的依據,使其輸出對於事實和時間敏感的查詢更加可靠。這種可靠性是 Perplexity Pro 的優點. .👉DeepSeek推理;Perplexity驗證。.

👉 DeepSeek 推演推理;Perplexity 驗證結果。.

3. 自主性

深度搜尋 每條提示產生一個答案。. 困惑 執行多步驟的研究循環——規劃、搜尋、閱讀與精煉——通常運用數十種資料來源。.

👉 DeepSeek 回應;Perplexity 調查。.

4. 準確性

深度搜尋 在數學與邏輯基準測試中表現優異。. 困惑 憑藉檢索、過濾與引用工作流程,在現實世界的實事準確性方面表現卓越。.

👉 DeepSeek 在純粹推理方面勝出;Perplexity 在證據支持的答案方面勝出。.

基準差異:各系統表現更優之處

基於公開可取得的數據:

DeepSeek R1 與 R1-1776 展現最強的原始推理能力, 反映其連貫的思考優勢,不受檢索限制。.

經困惑度調整的R1-1776模型實現了最高的事實準確度, 透過即時搜尋與多來源驗證技術的加持。.

Perplexity 的檢索依賴性是刻意設定為較高的, 由於其模型屬於更廣泛的研究管道的一部分,而非獨立系統。.

自主性是Perplexity脫穎而出的關鍵所在—它執行多步驟計畫、重新查詢並整合來源,而DeepSeek模型則以單次通過模式運作。.

總體而言,這張圖表突顯了一個核心真相: DeepSeek 提供原始推理能力;Perplexity 將此能力轉化為結構化的研究引擎.

困惑度 vs DeepSeek:定價、價值與您獲得的內容

| 功能/方案 | 困惑消除 | Perplexity Pro | DeepSeek R1(原始版) | DeepSeek R1-1776 |

| 價格 | $0 / 月 | $20 / 月 $200 每年 | 免費(開放重量) | 免費(開放重量) |

| 型號存取 | 困惑基礎模型 | GPT-4.1、Claude 3.5/4.x、R1-1776、o3-mini 等. | R1推理模型 | R1-1776 未經審查版本 |

| 即時搜尋 | 有限 | 無限 | ❌ 無 | ❌ 無 |

| 深度研究模式 | 限額配額 | 無限 | ❌ 不適用 | ❌ 不適用 |

| 引用 | 是 | 是 | ❌ 無檢索結果 | ❌ 無檢索結果 |

| 多階段自主研究 | ❌ | 是 | ❌ | ❌ |

| API 存取權限 | 沒有 | 包含 | 是(透過模型權重) | 是(透過模型權重) |

| 使用成本 | 免費 | 固定訂閱 | 免費(需運算資源) | 免費(需運算資源) |

DeepSeek 完全免費, 但使用者必須自行處理運算、設定,以及缺乏檢索或自動化的問題。.

PerplexityProcosts $20/月, 提供整合式研究引擎,包含搜尋、引文和多步工作流程。您可以在 困惑訂閱計劃 來決定。.

歸根結柢: DeepSeek 最便宜;; 困惑提供最高的實用價值 用於現實世界的研究。.

何時使用 困惑 vs 何時使用 DeepSeek

使用 DeepSeek 時

- 你需要數學推理

- 你想要清晰的思考鏈條

- 您正在本地或自訂工作流程中執行模型

- 您不需要即時數據或引用

使用 困惑 當

- 您需要經過驗證的事實

- 您需要多來源聚合

- 您需要快速的研究報告

- 您從事金融、行銷、時事評論或學術評鑑工作

- 您需要引用來源

為何 困惑 修改 DeepSeek 取代建立新模型

簡短回答: 速度 + 成本 + 效能的協同效應. DeepSeek R1 提供了強大的推理骨幹;; Perplexity 補充了 DeepSeek 所欠缺的片段:

- 檢索接地

- 資料驗證

- 工作流程自動化

- 無偏見的訓練後分析

- 使用者介面與平台執行

這種協同效應正是整合改變市場對話的原因。.

結論:你該選擇哪一個?

Perplexity 是可靠研究、事實查詢及時間敏感任務的更佳選擇。DeepSeek 則更適合原始推理、數學運算與離線模型執行。多數使用者無需抉擇——兩者互補性極佳,諸如 GlobalGPT 讓您輕鬆同時使用兩者 在一個流線型、經濟實惠的工作空間中並列運作。.