Perplexity und DeepSeek spielen unterschiedliche Rollen: DeepSeek bietet offene Gewichtsmodelle wie R1 und das unzensierte R1-1776, während Perplexity diese Modelle durch Hinzufügen von Echtzeit-Suche, mehrstufiger Planung und autonomer Berichterstellung zu einer vollständigen Suchmaschine macht. Im Jahr 2025 besteht der wesentliche Unterschied darin, dass Perplexity die Rohlogik von DeepSeek durch Abruf und Verifizierung verbessert und so zuverlässigere Ergebnisse für komplexe oder sachliche Fragen liefert.

Da Perplexity und DeepSeek unterschiedliche Teile des Arbeitsablaufs abdecken, erzielen viele Benutzer die besten Ergebnisse, wenn sie die beiden Tools kombinieren - oder sie mit Tools kombinieren, die Suche, Argumentation und Erstellung vereinen. Wenn Sie Folgendes erforschen Alternativen zur Perplexität, ist es wichtig zu verstehen, wie sich diese Modelle unterscheiden und integrieren lassen. Der wahre Wert entsteht, wenn diese Funktionen an einem Ort und nicht in mehreren Anwendungen vorhanden sind.

Eigentlich, GlobalGPT bietet einen einheitlichen All-in-One-Arbeitsbereich. Hier haben Sie Zugriff auf fortschrittliche Modelle, wodurch es einfacher wird, Modelle wie DeepSeek, Gemini, Claude oder GPT-5.1 nebeneinander zu bewerten – und das mit nur 1 TP4T5.75 pro Monat.

Wie Perplexität Verwendet DeepSeek R1 und R1-1776 in seinem System

| Modellversion | Widerstand gegen Zensur | Tiefgang der Argumentation | Faktische Grundlage | Integration mit Abruf | Autonomiestufe |

| DeepSeek R1 (Rohdaten) | Sehr gering – stark ablehnend gegenüber politischen und sensiblen Themen | Starke Gedankenkette, aber inkonsistent | Mäßig; oft ohne Überprüfung | Keine — nur Modell | Niedrig (erfordert Benutzereingaben bei jedem Schritt) |

| R1-1776 (offene Gewichte) | Hoch – unzensiert für sachliche, unzensierte Antworten | Gleiche Begründung wie R1; leicht verbesserte Struktur | Höher – umfasst überwachte sachliche Korrekturen | Keine | Niedrig bis mittel (immer noch ein eigenständiges Modell) |

| Perplexität-modifiziertes R1-1776 | Höchste Stufe – Zensur gemildert + Umgehung der Ablehnung | Stärkere mehrstufige Planung durch Agent-Schleife | Dank Echtzeit-Abruf deutlich höher | Tiefe Integration mit Suche, Quellenbewertung, Filterung | Hoch – autonome Recherche, Multi-Search-Workflow |

Die Entscheidung von Perplexity zur Integration DeepSeek R1 – und später die unzensierte Version R1-1776—ging es nicht darum, die bestehende Architektur zu ersetzen, sondern darum, den Denkprozess hinter der Deep Research-Engine zu stärken. R1 bietet einen langen Gedankengang, mehrstufige Schlussfolgerungen und strong Leistung bei akademischen Benchmarks, während R1-1776 die Zensurmuster beseitigt, die das Modell bei politischen, geopolitischen und sensiblen Sachfragen stark eingeschränkt haben.

Um zu sehen, wie dieses Modell im Vergleich zu anderen Modellen abschneidet, lesen Sie welches LLM verwendet Perplexity.

Perplexität nach dem Training zusätzlich angewendet R1-1776 an den Zielen der Plattform auszurichten:

- Beseitigung voreingenommener oder staatlich beeinflusster Ablehnungen

- Verstärkung der Faktenbasis durch abrufbasierte Feedbackschleifen

- Verbesserung der Argumentation, um autonom mit Multi-Search-Planung zu arbeiten

- Integration des Modells in Deep Research Arbeitsablauf

Aus diesem Grund verhält sich die interne Version von R1-1776 von Perplexity anders –und oft besser – als die Ausführung der rohen DeepSeek-Open-Weights lokal.

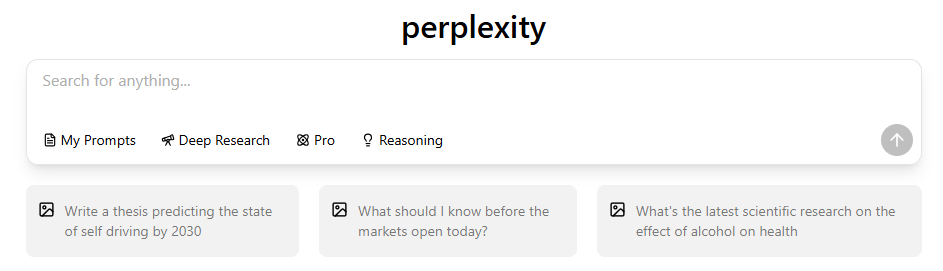

Ihre zuvor hochgeladenen “Deep Research Screenshots” kann hier als visuelle Erklärung dieses Prozesses eingefügt werden.

Was DeepSeek R1 und R1-1776 leisten sollen

DeepSeek R1 ist ein offenes Schlussfolgerungsmodell, das für Aufgaben mit langen Gedankengängen wie mathematische Beweise, logische Rätsel, mehrstufige Planungen und akademische Bewertungen optimiert ist. Seine Architektur begünstigt stark strukturiertes Denken gegenüber Kreativität, Gesprächstiefe oder multimodalen Funktionen.

Der unzensierte R1-1776 modifiziert Sicherheitsschichten, um politische Ablehnungsmuster zu beseitigen, wodurch er zuverlässiger wird für:

- Geopolitische Fragen

- Umstrittene historische Analyse

- Politische Modellierung

- Untersuchungen sensibler Regionen

- Ideologisch voreingenommene Themen

DeepSeek-Modelle sind ausgezeichnete Schlussfolgerungsmaschinen, aber keine vollständigen KI-Produkte— ihnen fehlen Echtzeit-Suchfunktionen, Benutzeroberflächen, Workflow-Orchestrierung und Systeme zum Abrufen von Datensätzen.

Wie Perplexität’s Real-Time Abrufänderungen beeinflussen das Verhalten von R1

Selbst das beste Argumentationsmodell kann zu falschen Schlussfolgerungen führen, wenn es von zuverlässigen Daten isoliert ist. Perplexity löst dieses Problem, indem es DeepSeek R1 auf seine Suchmaschine aufsetzt:

- R1 schlägt Hypothesen vor

- Perplexity ruft Dutzende von Live-Quellen ab

- R1 verfeinert die Argumentation anhand verifizierter Daten.

- Deep Research fasst den endgültigen strukturierten Bericht zusammen.

Diese Rückkopplungsschleife verwandelt R1 von einer Offline-Schlussfolgerungsmaschine in eine Autonomes System in Forschungsqualität.

Für Benutzer, die tiefergehende Funktionen benötigen, ist dies ein zentraler Bestandteil von was ist Perplexity Max.

Dies ist der Punkt, an dem Ihr Screenshot der Benutzeroberfläche von Deep Research passt perfekt.

Perplexity vs. DeepSeek: Wesentliche Unterschiede (Überblick 2025)

| Merkmal / Dimension | Perplexität | DeepSeek (R1 / R1-1776) |

| Abfragenauigkeit | Hoch für sachbezogene, zeitkritische Fragen aus mehreren Quellen (abrufgestützt) | Hoch in Logik, Mathematik und Argumentation; variabel bei sachlichen Fragen |

| Umgang mit sensiblen Themen | Stabil – nutzt Abruf + Filterung; weniger anfällig für Halluzinationen oder Ablehnung | R1 lehnt häufig ab; R1-1776 antwortet, kann jedoch unbestätigt oder inkonsistent sein. |

| Benchmark-Leistung | Kein Modell, aber Deep Research erzielt gute Ergebnisse bei SimpleQA (93,91 TP3T) und Humanity’s Last Exam. | R1 schneidet bei Benchmarks zum logischen Denken gut ab; R1-1776 ähnlich, jedoch unzensiert. |

| Forschungsautonomie | Sehr hoch – mehrstufige Planung, verzweigte Suche, Synthese, Zitate | Niedrig – Einmalige Generierung ohne Suche oder Planung |

| Echtzeit-Suche | Ja – integriert Websuche, Quellenbewertung und Zitatauszug | Nein – Modelle arbeiten offline ohne Abruf. |

| Benutzer-Workflows | Vollständige Arbeitsabläufe: Tiefgehende Recherche, PDF-Export, Seiten, Zusammenfassungen, Zitate, Synthese aus mehreren Quellen | Nur Modell; Workflows müssen vom Entwickler erstellt werden. |

1. Modell vs. Produkt

DeepSeek ist ein offenes Gewicht Modell Für Entwickler entwickelt. Perplexitätist ein vollständiges Forschungsprodukt — Kombination von Modellen mit Echtzeit-Suche, Quellenbewertung, Workflows und einer ausgefeilten Benutzererfahrung.

👉 DeepSeek ist eine Komponente; Perplexity ist ein komplettes System.

2. Argumentation vs. verifizierte Antworten

DeepSeek liefert starke Argumente, jedoch ohne Quellenangaben oder Zitate. Perplexität begründet jede Antwort mit externen Quellen, was die Zuverlässigkeit der Ergebnisse bei sachlichen und zeitkritischen Abfragen erhöht. Diese Zuverlässigkeit ist ein Markenzeichen von Vorteile von Perplexity Pro. 👉 DeepSeek begründet; Perplexity prüft.

👉 DeepSeek begründet; Perplexity überprüft.

3. Autonomie

DeepSeek generiert eine Antwort pro Eingabeaufforderung. Perplexität führt mehrstufige Recherchezyklen durch – Planung, Suche, Lesen und Verfeinerung – und nutzt dabei oft Dutzende von Quellen.

👉 DeepSeek antwortet; Perplexity untersucht.

4. Genauigkeit

DeepSeek zeichnet sich in Mathematik und Logik aus. Perplexität zeichnet sich durch seine Genauigkeit in Bezug auf Fakten aus der realen Welt aus, dank Workflows für das Abrufen, Filtern und Zitieren von Informationen.

👉 DeepSeek gewinnt in puncto reinem logischen Denken; Perplexity gewinnt in puncto evidenzbasierten Antworten.

Benchmark-Unterschiede: Wo jedes System besser abschneidet

Basierend auf öffentlich zugänglichen Daten:

DeepSeek R1 und R1-1776 weisen die stärkste Rohlogik auf., was ihre Stärken in der Gedankenkette ohne Abrufbeschränkungen widerspiegelt.

Das perplexitätsmodifizierte R1-1776 erreicht die höchste faktische Genauigkeit., unterstützt durch Echtzeit-Suche und Überprüfung aus mehreren Quellen.

Die Abrufabhängigkeit ist bei Perplexity absichtlich hoch., da sein Modell Teil einer umfassenderen Forschungspipeline und kein eigenständiges System ist.

Autonomie ist das, was Perplexity von anderen unterscheidet.—Es führt mehrstufige Pläne aus, führt erneute Abfragen durch und synthetisiert Quellen, während DeepSeek-Modelle im Single-Pass-Modus arbeiten.

Insgesamt verdeutlicht das Diagramm eine zentrale Erkenntnis: DeepSeek bietet rohe Rechenleistung; Perplexity verwandelt diese Leistung in eine strukturierte Suchmaschine..

Perplexity vs. DeepSeek: Preise, Wert und was Sie dafür bekommen

| Merkmal/Plan | Verwirrungsfrei | Perplexity Pro | DeepSeek R1 (Rohdaten) | DeepSeek R1-1776 |

| Preis | $0 / Monat | $20 / Monat $200 jährlich | Kostenlos (offenes Gewicht) | Kostenlos (offenes Gewicht) |

| Modell Zugang | Perplexity-Basismodell | GPT-4.1, Claude 3.5/4.x, R1-1776, o3-mini usw. | Nur R1-Argumentationsmodell | R1-1776 unzensierte Variante |

| Echtzeit-Suche | Begrenzt | Unbegrenzt | ❌ Keine | ❌ Keine |

| Tiefgreifender Forschungsmodus | Begrenzte Quote | Unbegrenzt | ❌ Nicht verfügbar | ❌ Nicht verfügbar |

| Zitate | Ja | Ja | ❌ Keine Abfrage | ❌ Keine Abfrage |

| Mehrstufige autonome Forschung | ❌ | Ja | ❌ | ❌ |

| API-Zugang | Nein | Enthalten | Ja (über Modellgewichte) | Ja (über Modellgewichte) |

| Nutzungskosten | Kostenlos | Festes Abonnement | Kostenlos (Rechenleistung erforderlich) | Kostenlos (Rechenleistung erforderlich) |

DeepSeek ist völlig kostenlos., aber die Benutzer müssen sich selbst um die Berechnung, Einrichtung und den fehlenden Abruf oder die fehlende Automatisierung kümmern.

PerplexityProcosts $20/Monat, und bietet eine integrierte Recherchemaschine mit Suche, Zitaten und mehrstufigen Workflows. Sie können die Details auf Perplexity-Abonnementpläne zu entscheiden.

Unterm Strich: DeepSeek ist am günstigsten.; Perplexität bietet den höchsten praktischen Wert. für die Forschung in der Praxis.

Wann zu verwenden Perplexität vs Wann sollte DeepSeek verwendet werden?

Verwenden Sie DeepSeek, wenn

- Sie benötigen mathematisches Denkvermögen.

- Sie möchten eine transparente Gedankenkette.

- Sie führen Modelle lokal oder in benutzerdefinierten Workflows aus.

- Sie benötigen keine Echtzeitdaten oder Zitate.

Verwenden Sie Perplexität Wenn

- Sie benötigen überprüfte Fakten.

- Sie benötigen eine Aggregation aus mehreren Quellen.

- Sie möchten schnelle Forschungsberichte

- Sie arbeiten in den Bereichen Finanzen, Marketing, Zeitgeschehen oder akademische Rezensionen.

- Sie benötigen Quellenangaben.

Warum Perplexität Modifiziertes DeepSeek anstelle der Erstellung eines neuen Modells

Kurze Antwort: Geschwindigkeit + Kosten + Leistungssynergie. DeepSeek R1 bot eine starke Grundlage für die Argumentation.; Perplexity fügte die Teile hinzu, die DeepSeek fehlten:

- Abruf-Erdung

- Datenüberprüfung

- Workflow-Automatisierung

- Unvoreingenommenes Post-Training

- Benutzeroberfläche und Plattformausführung

Die Synergie ist der Grund, warum die Integration die Marktgespräche verändert hat.

Fazit: Für welches Produkt sollten Sie sich entscheiden?

Perplexity ist die bessere Wahl für zuverlässige Recherchen, sachliche Abfragen und zeitkritische Aufgaben. DeepSeek ist die bessere Wahl für rohe Schlussfolgerungen, Mathematik und die Offline-Ausführung von Modellen. Die meisten Nutzer müssen sich nicht entscheiden – beide Tools ergänzen sich hervorragend, und Plattformen wie GlobalGPT macht die Verwendung beider Funktionen einfach. Seite an Seite in einem optimierten, kostengünstigen Arbeitsbereich.